Comment réaliser des A/B tests qui apportent de RÉELS learnings ? 🕵️

Taille minimale d'échantillon, Metric de succès, Minimum detectable effect... On s'attaque aujourd'hui à l'A/B test !

L’A/B test est une des manières les plus courantes d’expérimenter en Growth ou Product.

Mais la vaste majorité des A/B tests réalisés ne suivent aucune méthode claire. Résultat ?

On se retrouve la plupart du temps avec des résultats non significatifs.

Ou pire, avec des résultats biaisés qui nous amènent à déclarer une version gagnante qui ne l’est probablement pas.

Et la, c’est la catastrophe : vous perdez littéralement de l’argent en pensant en faire gagner. 🤦♂️

Heureusement, il existe des méthodes et outils qui permettent de construire des A/B tests fiables.

Et l’A/B test est une arme redoutable dont il ne faut absolument pas se passer lorsque l’on cherche à driver de la croissance.

L’A/B Test : Une arme redoutable pour générer de la croissance 💥

Le concept de l’A/B test est assez simple.

Avant de déployer une nouvelle version d’un contenu existant (un variant), on teste et compare les performances du variant aux performances du contenu original.

On définit une metric de succès, qui est généralement le taux de conversion.

On redirige une partie de notre audience vers la version A, une autre partie vers la version B.

Puis on sélectionne le variant gagnant → celui qui obtient le meilleur score par rapport à notre metric de succès.

Il nous permet de valider ou non une hypothèse préalablement définie.Par la suite, on améliore petit à petit nos metrics en répétant ces tests dans le temps.

L’A/B test est une mine d’or pour débloquer sa croissance en optimisant les étapes de son funnel AARRR (Acquisition - Activation - Rétention - Referral - Revenue).

🛠 Facile à implémenter : De nombreux outils no-code permettent de par exemple construire un variant d’une page existante en quelques minutes.

📈 Simple à tracker : On cherche à améliorer de l’existant sur lequel on possède déjà de la data. Il est donc simple de détecter une amélioration.

📚 Tout contenu peut s’A/B tester : Que ce soit un programme de referral, un objet d’e-mail, une google AD…le champ des possibles est incroyable.

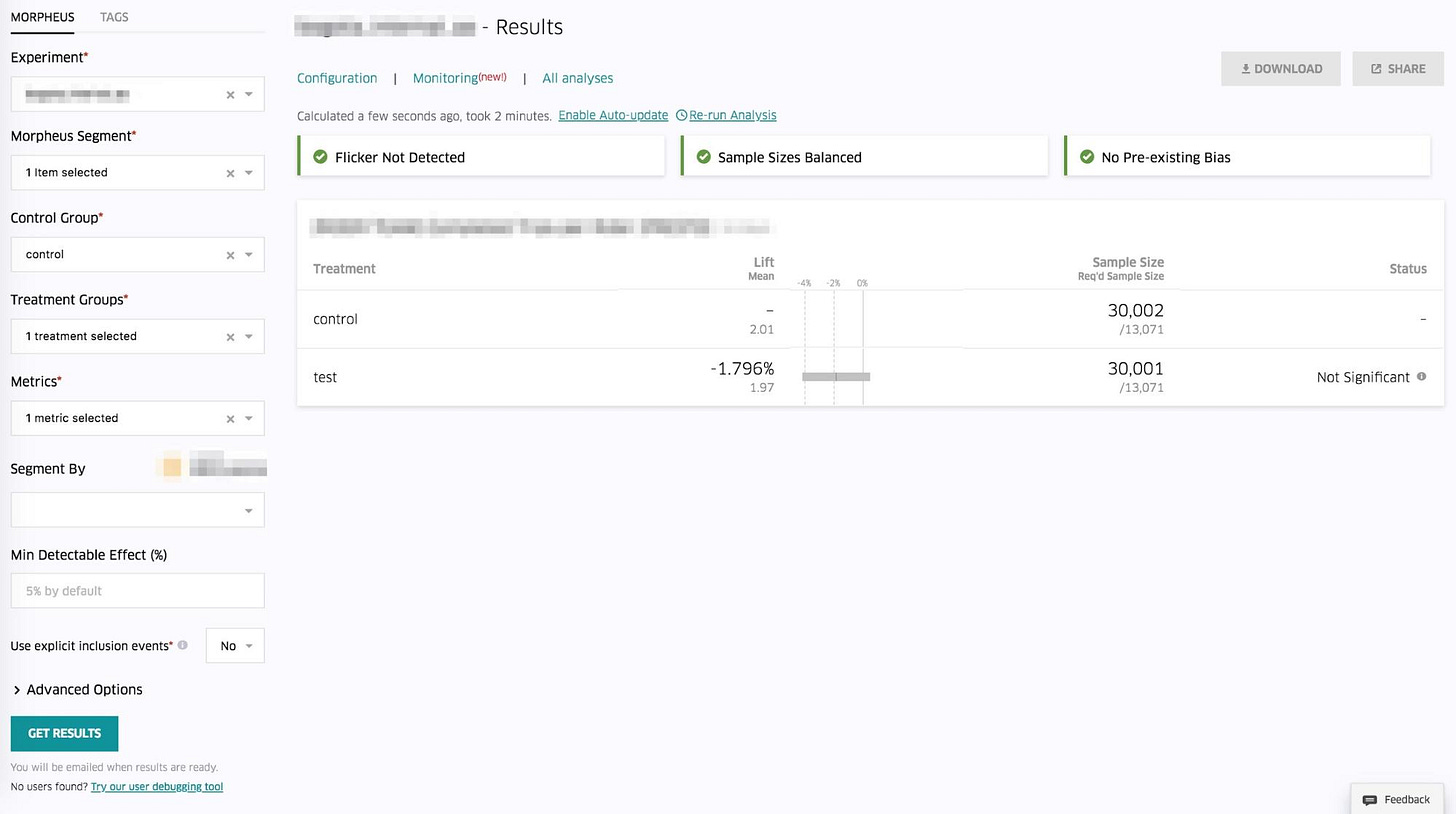

Uber fait parti des champions de l’A/B test (et de l’expérimentation Growth en général), à tel point que leur équipe Tech a développé une solution maison : Morpheus ⬇️

Cette plateforme permet de réaliser des A/B tests précis et poussés. La menu de gauche sert à définir les différents paramètres nécessaires à la réalisation du test.

Pour comprendre l’impact que l’A/B testing peut avoir sur le revenu, prenons un exemple concret 👇

Je possède un e-commerce de ventes d’accessoires pour animaux.

Chaque mois, 10k personnes visitent ce site.

Sur 10k monthly visitors, ils sont :

800 à réaliser un ajout au panier → 8% de taux d’ajout au panier.

400 à acheter un produit → 4% de taux conversion global.

Mon panier moyen est de 50€, je réalise donc 20k€ de CA chaque mois, 240k€ à l’année.

Je décide de lancer un A/B test ayant pour objectif d’améliorer le taux d’ajout au panier (8%). J’ajoute un bandeau “Made in France 🇫🇷” sur mes pages produits pour augmenter la valeur perçue de mes produits et rassurer mes utilisateurs.

Le taux d’ajout au panier grimpe à 10% (vs 8%). Mes autres taux de conversions et mon panier moyen restent stables, ma conversion globale augmente et passe à 5%.

Je vends désormais 500 articles par mois (+100) et réalise 25k€ de CA mensuel (+5k€).

Mon A/B test réussi me permet de générer +60k€ de CA annuel supplémentaire. 💸

Bien entendu, une partie des A/B tests échouent, c’est le jeu de l’expérimentation. C’est pourquoi on test sur des périodes/audiences limitées avant de déployer, pour trouver un variant qui pourra être déployé à échelle.

Le concept semble simple ? Sur le papier, oui. Dans la pratique, la plupart des A/B tests sont mal préparés et/ou mal éxécutés.

Parmi les erreurs les plus communes, on retrouve :

❌ Ne pas définir la taille critique de son échantillon → Les résultats sont trompeurs ou non significatifs. L’erreur peut coûter cher en nous amenant dans une mauvaise direction.

❌ Ne pas clairement définir sa metric de succès → Un A/B test ne sera concluant que si l’on sait réellement ce qu’on cherche à améliorer.

❌ Tester plusieurs éléments en même temps → On teste plusieurs nouveaux éléments sur notre variant (CTA, image et ajout de reviews sur une landing page par exemple). Le variant testé obtient un meilleur taux de conversion et est donc déclaré gagnant. Sauf que l’on n’a aucune idée de quel élément est à l’origine de l’uplift de conversion. Les learnings deviennent biaisés.

Pas de panique, on regarde ensemble comment réaliser un A/B test fiable, qui permet de récolter de VRAIS learnings. Et faire grossir son revenu. 💰

Comment réaliser un A/B test qui cartonne avec Google Optimize ? 🥊

Réaliser un bon A/B test qui apporte de RÉELS learnings est devenu accessible à tous grâce aux outils et méthodes existants.

Pour construire notre A/B test, mettons-nous dans la peau d’un Growth Manager de Shopify dont l’objectif est d’augmenter le taux de conversion de la homepage du site Français.

1️⃣ Quelle est notre hypothèse ?

Nous pensons qu’il est possible d’augmenter le taux de conversion de la homepage Shopify FR en affinant notre proposition de valeur.

Nous allons donc tester une nouvelle version de la headline du site.

Avec Google Optimize, un des tools d’A/B testing les plus populaires (Optimizely et AB tasty , qui permet de réaliser des tests plus poussés, sont également des outils couramment utilisés), nous allons créer un variant de la homepage actuelle.

Nous avons pour information en moyenne 20,000 daily visitors sur le site.

2️⃣ Quel est notre objectif, la metric que l’on souhaite améliorer ?

Le taux de conversion de la homepage du site.

Pour Shopify, est considérée comme conversion un user qui ajoute son email et clique sur “Essayer gratuitement”.

3️⃣ Quel est le minimum detectable effect visé ?

Notre taux de conversion actuel est de 7%.

Pour déclarer un variant gagnant, nous souhaitons que l’uplift du taux de conversion (le minimum detectable effect) soit minimum de 10%, pour atteindre un taux de conversion de 7,7% à minima.

Si ce minimum detectable effect de 10% n’est pas atteint, notre test sera déclaré comme non concluant.

4️⃣ Sur quelle audience souhaite t’on déployer l’A/B test ?

Tous les visiteurs de la homepage FR, avec une répartition de 50% (“Evenly split”) pour chacun de nos deux variants.

5️⃣ Quelle est la taille minimale de notre échantillon et le temps de run nécessaire à cet A/B test ?

Il faut bien avoir en tête que pour tirer des conclusions significatives d’un A/B test, de nombreux paramètres entrent en jeu :

le taux de conversion actuel

le minimum detectable effect (qui est l’uplift de conversion visé)

l’indice de confiance dans les résultats

le nombre de visiteurs exposés à chacun des variants

le temps de run de l’A/B test

Grâce à nos hypothèses définies en amont, on se sert d’un “Sample Size Calculator” pour calculer la taille de notre échantillon. Cela nous permet d’éviter pas mal de formules statistiques plutôt complexes.

Nous utilisons ici ce calculateur proposé par A/B tasty (des dizaines de solides alternatives sont accessibles via une simple recherche Google).

Pour maximiser nos chances de tirer des conclusions utiles, nous allons entrer 95% dans la case “Statistical Significance” : c’est l’indice de confiance communément visé pour des A/B tests.

Au vu de nos hypothèses, nous allons devoir :

pousser chaque variant à +21k users

faire tourner l’A/B test durant 2 jours à minima

Google Optimize recommande de runner des A/B tests pendant 14 jours, mais je déconseille personnellement de faire durer beaucoup plus si les niveaux de confiance sont élevés une fois ce délai passé.

Comment faire si mon site a peu de traffic ?

Il n’est pas rare, notamment en phase de lancement ou sur du B2B très ciblé, que le traffic journalier de votre site web soit faible. Dans ce cas, pour éviter de trop faire baisser notre indice de confiance en les résultats, il faut chercher à détecter un uplift (le “Minimum detectable effect”) élevé. Plus ce score est élevé, moins le nombre de visiteurs requis pour le test sera élevé.

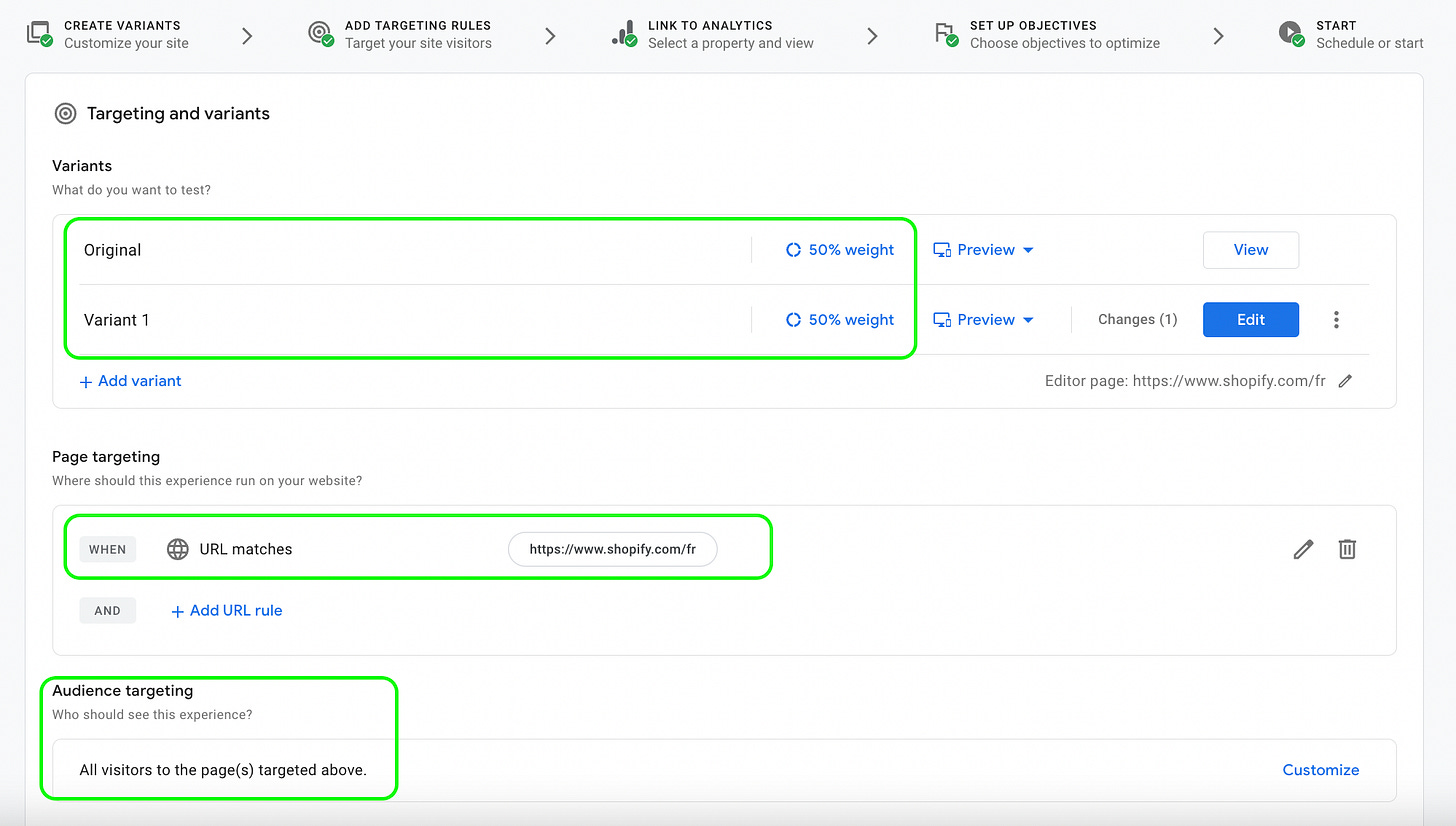

7️⃣ On peut désormais passer à la construction de notre A/B test avec Google Optimize 👇

Suite à notre travail préalable, nous n’avons qu’à remplir quelques informations sur Google Optimize et créer notre variant pour lancer notre A/B test.

Optimize permet de réaliser très simplement les modifications de notre landing page initial via un éditeur no-code :

On se rend ensuite dans le Dashboard Google optimize, dans le 1er encart “Targeting and variants” pour définir :

la répartition du traffic sur chaque variant → ici, notre audience est “evenly split”. 50% des visiteurs verront la version originale, 50% le variant.

la page sur laquelle on souhaite appliquer le test → la homepage FR de Shopify.

l’audience targetée → tous les visiteurs.

Pour la mesure du succès de l’A/B test :

On connecte son Google Analytics (disponible avec GA4 seulement) à Optimize.

Les objectifs de conversions sont remontés automatiquement depuis GA4 → on choisit de maximiser le nombre de “forms started” ici, qui correspond à l’évènement de conversion de notre homepage.

8️⃣ Analysons maintenant les résultats de notre A/B test 📈

Google Optimize nous propose un Dashboard reporting pour analyser nos résultats.

La metric la plus importante à regarder étant ici le “Probability to be Best”, qui permet de définir le succès ou l’échec de l’A/B test.

On peut conclure que cet A/B test est un échec, car notre homepage originale obtient une “Probability to be Best”" > 99%. L’indice de confiance est donc suffisamment élevé pour conclure ce test.

Vous devriez maintenant savoir lancer l’A/B test d’une landing page avec Google Optimize comme de vrais pros ✌️

Il faut bien comprendre que, dans notre exemple présenté ci-dessus, Google Optimize réalise une grosse partie du travail de calcul pour nous.

Il existe bien d’autre type d’A/B tests, ou la méthodologie est la même, mais ou le travail d’analyse statistique devra être réalisé de manière manuelle.

On peut par exemple imaginer un cas d’A/B test ou une application mobile cherche à détecter l’impact d’une notification Push quotidienne sur l’engagement de ses utilisateurs.

Pour comparer l’impact de cette notification Push, l’entreprise devra créer un control group et un experimental group :

Le control group ne reçoit pas de Push

L’experimental group reçoit une Push quotidienne

On comparera ensuite le taux d’engagement du control group VS experimental group pour comprendre l’impact de cette Push quotidienne.

A vous de jouer désormais 🧪

L’A/B test est un terrain de jeu incroyable que chaque entreprise, quelle que soit sa typologie ou son secteur, doit absolument appliquer.

En suivant des frameworks clairs, A/B tester régulièrement vos landing pages, ads, emails, vous permettra de réaliser des améliorations de vos contenus basés sur la donnée et non la perception.

Pour améliorer vos metrics business de manière incrémentale et débloquer des opportunités de croissance. 📈